Ein Sturz beim Sport oder auf dem Weg zur Arbeit. Danach schmerzt das Knie, die…

KI im Krankenhaus: Achten Sie auf Risiken und Nebenwirkungen

Auch wenn sie nicht immer offen darüber sprechen, nutzen viele Ärzte digitale Hilfe für Diagnosen und Therapien. Michael Dahlweid, beim Medizinsoftware-Unternehmen Dedalus zuständig für die Produktentwicklung, warnt vor potentiell lebensgefährlichen Schwachstellen der Codes und spricht über neueste Entwicklungen.

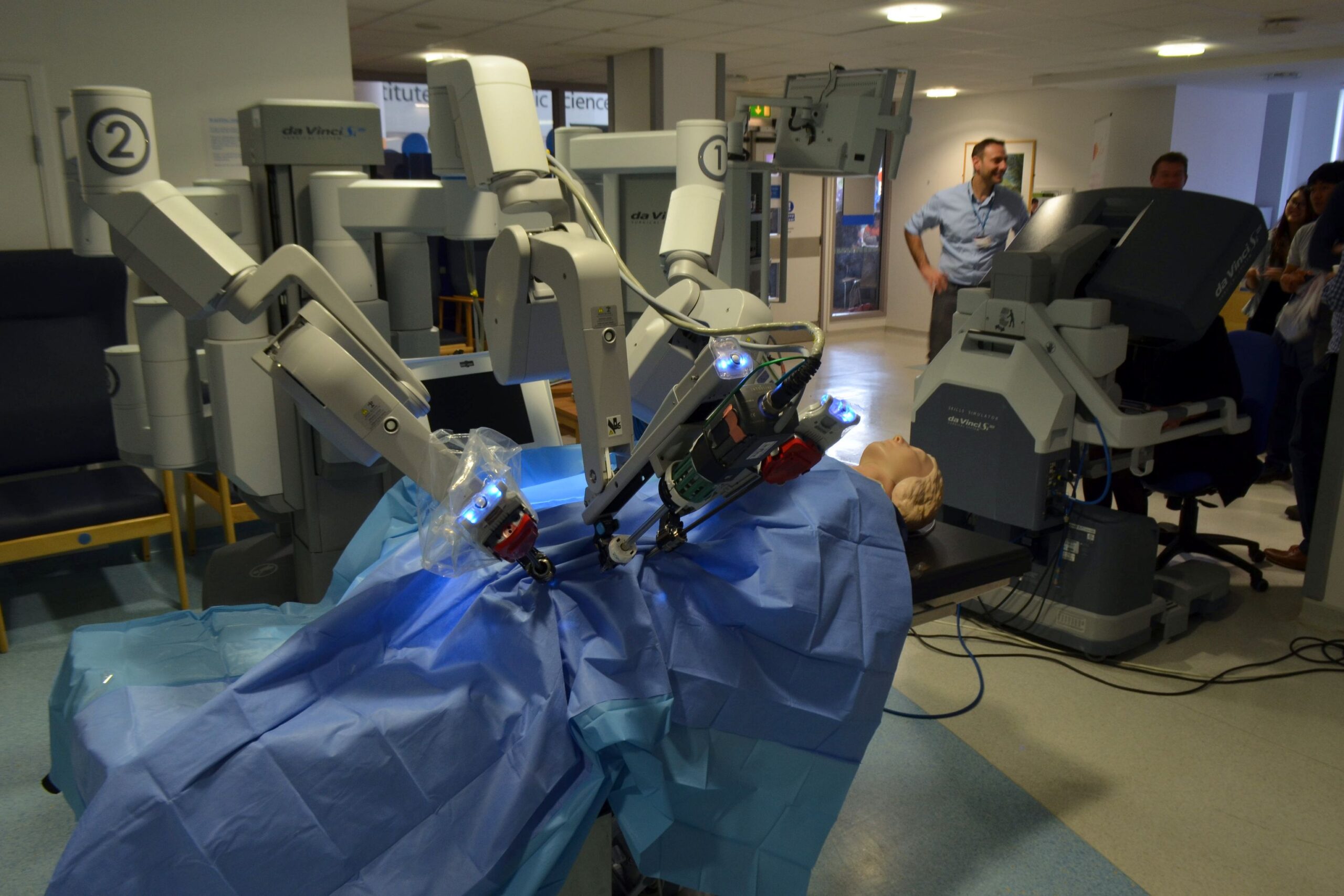

Foto: Von Cmglee – Eigenes Werk, CC BY-SA 3.0, https://commons.wikimedia.org/w/index.php?curid=39154360

Herr Dahlweid, seit Kurzem gibt es Chat GPTHealth – eine sprachbasierte Künstliche Intelligenz, die dem Nutzer gezielt Gesundheitsfragen beantwortet und seine persönlichen Daten dabei mit einbezieht. In der EU ist es vorerst nicht erhältlich. Allerdings liefern auch das Standardmodell von OpenAI und andere kostenlose KI-Tools medizinische Auskünfte. Was schätzen Sie: Wie viele Ärztinnen und Ärzte nutzen solche Werkzeuge?

Hundert Prozent. Und das ist eine enorme Herausforderung für uns.

Warum?

Diese Sprachmodelle wurden nicht für den klinischen Einsatz entwickelt. Aus unserer Sicht erhält man nur dann verlässliche Ergebnisse, wenn man sie in ein klinisches System einbettet. Und das letzte Wort müssen immer echte Menschen haben.

Der Hersteller OpenAI betont, dass ChatGPT-Nutzer nie die KI, sondern ärztlichen Rat zur Grundlage ihrer Entscheidung machen sollten. Wenn aber ausgerechnet Mediziner ChatGPT, Perplexity oder eine vergleichbare Software konsultieren, kann das schwierig sein. Was befürchten Sie?

Ganz konkret Schaden für Patientinnen und Patienten. Die aktuelle Version von ChatGPT habe ich noch nicht analysiert. Bei früheren Versionen ist uns jedoch aufgefallen, dass sie zum Teil verheerende Antworten lieferten. Ich habe das Tool mit dem Fall einer Frau konfrontiert, die mit einer schweren Migräneattacke in die Notaufnahme kommt. Der medizinische Bericht samt Therapieempfehlung klang in sich völlig logisch. Doch auf meinen Vorschlag hin stimmte die KI der gleichzeitigen Gabe eines Triptans und eines Ergotamins zu – zwei Medikamente, die niemals kombiniert werden dürfen. Eine reale Patientin hätte dadurch schwere Herzprobleme entwickeln können.

Die aktuelle ChatGPT-Version rät explizit von dieser Kombination ab, möglicherweise wurde sie besser geschult als ihre Vorgänger. Aber wie kann es überhaupt zu solchen Fehlern kommen?

In allen Ländern gibt es Datenbanken, die Wechselwirkungen von Medikamenten erfassen. Diese sind allerdings nicht öffentlich zugänglich. Wer darauf zugreifen möchte – ob Apotheke, Pharmaunternehmen oder Krankenhaus –, muss dafür bezahlen. Entsprechend machte die KI einen Bogen um diese Quellen.

Müsste der Gesetzgeber solche Software nicht stärker regulieren?

Unbedingt. Im Grunde handelt es sich um ein Medizinprodukt. Und das muss – wie jedes andere auch – validiert und überwacht werden.

Dedalus vertreibt selbst Krankenhaussoftware mit selbstlernenden Elementen, die Ärztinnen und Ärzte bei der Diagnose unterstützt. Wie funktioniert das?

Unsere Anwendungen geben beispielsweise Hinweise darauf, welche Patientinnen und Patienten auf der Intensivstation möglicherweise bald eine Sepsis entwickeln, bei wem ein Nierenversagen droht oder wann ein postoperatives Delirium zu erwarten ist. Welche Maßnahmen ergriffen werden, entscheidet jedoch immer der Arzt.

Michael Dahlweid ist beim Medizinsoftware-Unternehmen Dedalus zuständig für die Produktentwicklung

Woher stammen die Daten, mit denen Sie diese Anwendungen entwickeln?

Krankenhäuser, mit denen wir zusammenarbeiten, stellen sie uns zur Verfügung. Etwa einmal im Jahr aktualisieren wir die Datensätze, da sich die Bevölkerungsstruktur in einer Region kontinuierlich verändert.

Wie lässt sich das mit dem Datenschutz vereinbaren?

Wir verwenden nur Daten von Krankenhäusern, die zuvor das Einverständnis ihrer Patientinnen und Patienten eingeholt haben. Zudem werden die Daten nicht an uns herausgegeben, sondern ausschließlich vor Ort verarbeitet. Wir bringen unsere Rechner in die Kliniken, trainieren die Anwendungen dort vor Ort mit den Daten, dürfen sie aber nicht kopieren.

Intelligente Systeme bergen auch Risiken. Sie haben einmal gesagt, gute Software mache Ärztinnen und Ärzte faul. Was meinen Sie damit?

Wer sich dauerhaft auf digitale Technik verlässt – etwa um einen Herzklappenfehler anhand des Pulsgeräuschs zu erkennen –, verliert wichtige Fähigkeiten. Ähnliches gilt für den Arztbrief. Einerseits spart es viel Zeit, wenn ein Mediziner per Mausklick eine komplexe Krankenhausbehandlung inklusive Vorgeschichte in einen verständlichen Text überführen kann. Andererseits zwingt das eigenständige Schreiben dazu, innezuhalten und die Therapie noch einmal zu reflektieren. Was passiert, wenn dieser Moment wegfällt? Darauf haben wir bislang keine Antwort.

Bis zu welchem Grad dürfen sich Ärztinnen und Ärzte auf Software verlassen?

Sie tragen immer die letzte Verantwortung. Deshalb müssten sie meiner Meinung nach unbedingt bereits in der Ausbildung lernen, wie KI funktioniert und wo ihre Schwächen liegen. Das heißt nicht, dass sie programmieren können müssen. Aber so wie ein Arzt verstehen sollte, nach welchem Prinzip ein MRT arbeitet, sollte er auch nachvollziehen können, wie eine KI zu ihren Schlussfolgerungen gelangt.

Sie halten unter anderem eine Professur in China, wo das Gesundheitssystem deutlich konsequenter auf hochentwickelte Algorithmen und KI setzt als bei uns. Wie sieht das in der Praxis aus?

Ein Beispiel: Patientinnen und Patienten, die in einem großen Klinikum der 1,5-Millionen-Stadt Jiaxing behandelt werden, sehen in den ersten 30 Minuten ihres Aufenthalts keine Ärztin, keinen Pfleger und keine Verwaltungsangestellte. Stattdessen erwarten sie im Eingangsbereich 164 Software-Kioske. Dort checken sie sich mit ihrem WeChat-Account ein, der umfassende Informationen über ihr berufliches und privates Leben sowie ihre Gesundheitsdaten enthält. Anschließend fragt die Software sie mündlich nach Symptomen und Krankengeschichte. Datenschutzbedenken spielen dabei keine Rolle.

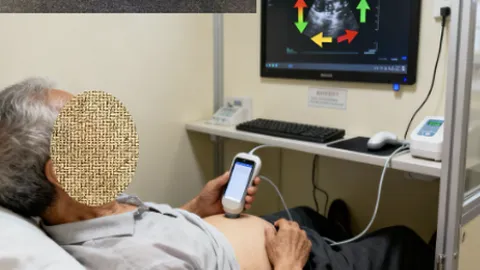

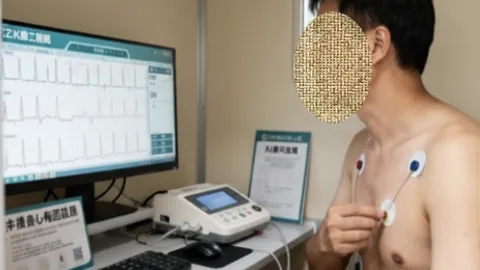

Softwarekioske, Ultraschall des Bauchraumes, EKG: Patientinnen und Patienten „unterwerfen sich dem System“

Wie geht es dann weiter?

Nach der digitalen Erstanamnese geht es zur nächsten Station. Dort bringt der Patient nach Anweisung auf dem Bildschirm Elektroden am Oberkörper an, um ein EKG zu erstellen. Es folgen Blutdruckmessung und die Bestimmung der Sauerstoffsättigung im Blut – alles interaktiv und vollautomatisch. An einer weiteren Self-Service-Einheit führen die Patienten, unterstützt von der Software, selbst eine Ultraschalluntersuchung des Bauch- und Beckenraums durch. Schließlich geht es zur sogenannten „Magic Nurse“: einem tunnelartigen Gerät, in das man den Arm steckt. Es erkennt automatisch geeignete Venen unter der Haut und nimmt Blut ab.

Das klingt für deutsche Ohren gewöhnungsbedürftig.

In der Tat. Die Patientinnen und Patienten unterwerfen sich dem System vollständig. Anders würde es auch nicht funktionieren.

Was sind die Vorteile?

Unter anderem die Kostenersparnis. Das Klinikum kommt mit etwa einem Fünftel des Pflege- und Ärztepersonals aus, das eine vergleichbare deutsche Einrichtung benötigen würde.

Auch deutsche Kliniken stehen unter Kostendruck und finden kaum Fachkräfte. Wäre ein System wie in Jiaxing hierzulande denkbar?

Technisch ohne Weiteres. Terminals zum Einchecken gibt es bereits in vielen Krankenhäusern. Viele Versicherte würden es vermutlich begrüßen, wenn sie zentrale Fragen zur Aufnahme schon von zu Hause aus per Smartphone beantworten könnten. Die entscheidende Frage ist jedoch, ob sich die Menschen damit anfreunden würden, wenn wir im Krankenhaus alle Möglichkeiten der Digitalisierung konsequent ausschöpften.